robots协议

日期:2026年2月16日Robots协议是网站与搜索引擎蜘蛛间的核心沟通机制,通过robots.txt文件明确抓取权限边界,既能引导蜘蛛高效索引高价值内容、节省服务器资源,又能屏蔽隐私页面与重复内容;但需警惕其无强制约束力的特性,合理配置User-agent、Disallow、Allow指令及Sitemap路径,结合Robots Meta标签实现精细化管控,避免因误封导致流量断崖,最终构建搜索引擎友好与站点安全兼顾的技术生态。

Robots协议是网站与搜索引擎蜘蛛间的核心沟通机制,通过robots.txt文件明确抓取权限边界,既能引导蜘蛛高效索引高价值内容、节省服务器资源,又能屏蔽隐私页面与重复内容;但需警惕其无强制约束力的特性,合理配置User-agent、Disallow、Allow指令及Sitemap路径,结合Robots Meta标签实现精细化管控,避免因误封导致流量断崖,最终构建搜索引擎友好与站点安全兼顾的技术生态。

向搜索引擎要流量要订单!一个好网站不仅要满足用户需求还要符合SEO规则。

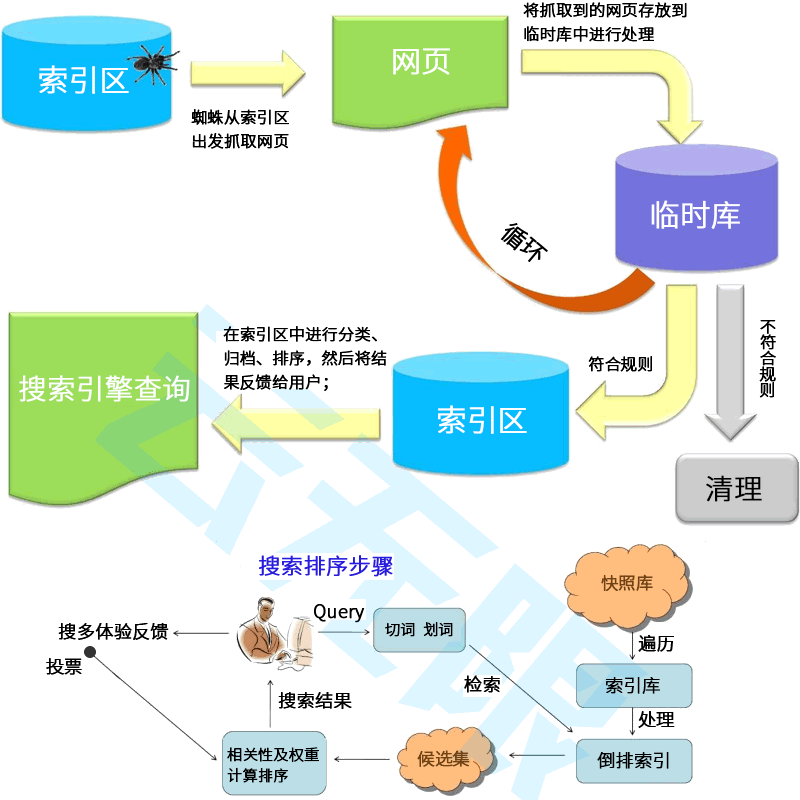

SEO的专业性远超你的想象!我们要做的是协助搜索引擎而不是欺骗它!它涉及到的不止是网站结构、内容质量、用户体验、外部链接这几个方面;还有算法的更替、蜘蛛的引导、快照的更新、参与排序的权重等。

一、让用户搜到你的网站是做SEO优化的目标,拥有精湛的SEO技术、丰富的经验技巧以及对SEO规则的深刻把握才有机会获得更多展现机会!

二、确保网站内容清晰、准确、易于理解,使用户能够轻松找到所需信息.使用简洁明了的标题和描述,帮助用户快速了解你的产品服务!

三、将企业的核心价值、差异化卖点、吸引眼球的宣传语等品牌词尽可能多的占位搜索前几页,增强用户印象,优化用户体验让访客信任你!

四、优化落地页引导用户咨询或预约留言,引用大型案例或权威报道彰显品牌实力,关注用户需求和反馈,不断优化产品服务让用户选择你!

让用户搜到你、信任你、选择你!

Robots协议(又称爬虫协议)是网站通过robots.txt文件告知搜索引擎哪些页面可抓取、哪些禁止抓取的约定规范。搜索引擎蜘蛛(Spider)访问站点时,首先检查根目录下是否存在该文件,依其指令确定抓取范围。需特别注意:该协议无强制执行力,搜索引擎可忽视协议抓取快照,且不能保障网站隐私安全,仅作为行业自律的平衡机制。

Robots协议诞生于1994年6月30日,由早期搜索引擎从业者与网站站长在公开邮件组共同讨论制定,被Altavista、Google、百度等全球主流搜索引擎采纳。其核心思想是要求爬虫程序自律,不检索站长不希望被搜索的内容,通过格式化代码实现搜索与被搜索的和谐共存。

robots.txt必须放置在网站根目录,访问路径为:https://www.example.com/robots.txt。蜘蛛首先检索此文件,若不存在则默认抓取所有非口令保护页面。错误放置将导致协议失效,增加蜘蛛无效工作量。

1. User-agent:指定适用爬虫名称,*代表所有爬虫,单文件仅能有一条"User-agent: *"记录;2. Disallow:禁止访问的URL路径(前缀匹配),单独Disallow:表示允许全部;3. Allow:允许访问的特定路径(通常用于Disallow目录下的例外开放);4. Sitemap:指定网站地图路径,辅助蜘蛛高效发现内容。

通配符支持:*匹配任意字符,$匹配行结束符。百度严格区分大小写,需精确匹配路径。

全站封禁:User-agent: * / Disallow: /;全站开放:User-agent: * / Allow: /(或空文件);单爬虫封禁:User-agent: Baiduspider / Disallow: /;特定目录屏蔽:Disallow: /cgi-bin/ / Disallow: /temp/(需分行声明);特定文件类型屏蔽:Disallow: /*.jpg$;动态页面屏蔽:Disallow: /*?*;组合权限控制:先Allow例外路径,再Disallow父目录。

在线生成:站长工具(tool.chinaz.com/robots/)、爱站(tools.aizhan.com/robots-generator/);合规检测:百度资源平台(ziyuan.baidu.com/robots/)、爱站检测工具、站长工具检测。

针对单页面精细化控制,在<head>区添加:<meta name="robots" content="index/noindex, follow/nofollow">。Index控制是否收录,Follow控制是否跟踪链接,组合成all(index,follow)或none(noindex,nofollow)。Google支持archive指令控制快照保留。

1. 屏蔽死链:将失效内链写入robots,避免蜘蛛无效抓取;2. 消除重复:禁止动态页面抓取,避免与静态副本内容重复;3. 节省资源:阻止蜘蛛爬取脚本、CSS等无意义文件,提升服务器性能;4. 隐私保护:封禁购物车、用户中心等敏感页面;5. 调试缓冲:网站改版或上线前全站封禁,完成调试后开放。

1. 必须添加robots.txt避免服务器记录404错误;2. 严禁禁止CSS/JS资源文件,影响搜索引擎解读页面;3. 动态网站需屏蔽原始动态URL;4. 在文件中直接声明Sitemap路径;5. 阻止蜘蛛直接进入购物车等转化页面;6. 控制友链数量在30条以内;7. 同IP站点交换不超过1个友链。

若误操作封禁全站,需立即执行:1.修改robots为允许状态,百度资源平台检测更新;2.多次点击抓取检测触发蜘蛛访问;3.申请上调抓取频次;4.百度反馈中心提交误操作说明;5.配置API实时推送;6.更新Sitemap并每日手动提交。通常3天左右流量恢复正常。

Q:文件是否必需?A:小型网站可省略,但建议配置以引导蜘蛛;Q:能否禁止资源文件?A:绝对禁止,会导致搜索引擎无法渲染页面;Q:协议能否保障隐私?A:不能,仅为约定无强制力,敏感内容需通过登录验证保护。

如果你的网站无法从搜索引擎获取流量和订单!说明你从一开始就没有建立正确的SEO策略。

1、不限关键词数量,不限关键词指数,自由扩展.

2、更懂用户搜索习惯、更懂SEO规则、更懂运营.

3、专业团队实施,量化交付、效果持续有保障.

1、让网站结构、内部标签及HTML代码等更符合SEO规则.

2、客户指定关键词,不限关键词指数,不上首页不收费.

3、提升搜索蜘蛛抓取效率、收录效率、排名展现和有效访问.

1、竞争对手分析,了解同行营销策略以及行业趋势.

2、关键词保证到谷歌首页带来高价值流量及询盘.

3、涵盖Google、Bing、Yahoo等所有搜索引擎友好抓取.

世界上从不缺产品,缺的是把产品卖出去的方法!云优化是北京专业的SEO公司,专注百度、谷歌、搜狗、360等搜索引擎优化服务。我们更懂用户搜索习惯、更懂SEO规则、更懂网站运营和SEO排名技术。

同等成本,让您的关键词排名更靠前;同样市场,为您锁定目标客户快速吸引询盘

用SEO技术让客户搜到你!让你的品牌词、核心词和产品词尽可能多的占位搜索首页让客户信任你!改进用户体验直达落地页,引导用户咨询或预约留言,突出产品差异化卖点,用案例和权威报道增强品牌公信力让客户选择你!

SEO网站优化是一项持续且精细化的工作,而非一劳永逸。它要求优化师密切关注行业动态,深入分析数据,并根据这些洞察不断调整和优化策略。云优化坚信,在SEO的旅程中,耐心和毅力是不可或缺的驱动力。只有持之以恒地投入努力,不断优化网站,才能在激烈的网络环境中脱颖而出,取得更为优异的搜索引擎排名。

搜索引擎优化聚焦于站内优化、站外SEO及搜索体验。以客户为中心,追求转化价值最大化,遵循用户需求和搜索规则,是成功的关键。文章作为优化的一环,不仅要满足读者,还需符合搜索引擎抓取规则。被收录的文章才有机会参与排序。因此,明确主题、合理结构、段落清晰,并结合关键词与主题的SEO规则创作,是文章发布的必备要素。

搜索引擎优化(SEO)与竞价推广共同构成了搜索引擎营销(SEM),因其精准满足客户搜索需求,成为中小企业网站营销的优选。SEM利用搜索引擎这一流量枢纽,精准捕获目标客户,助力品牌建设。无论在国内市场,借助百度、搜狗、360,还是国际市场,利用谷歌、必应、雅虎,SEM都能成为您营销的强大助力。无论国内还是国际,SEM都是一项高效、精准的营销策略。

许多优化师对SEO效果持疑,但云优化认为,这更多与网站SEO策略相关。关键词排名虽受多因素影响,但正确思维和规范操作是关键。在网站上线前,深入分析并调整SEO,确保站内优化到位。平衡用户需求和搜索引擎规则,可提升网站转化率。因此,科学的SEO策略将助力网站取得更好效果。